但正是这样的“常态”,却一直是自动驾驶行业的“沼泽地带”。

在自动驾驶过程中出现突发状况时,如何让驾驶者及时且安全地接管控制汽车是一个汽车行业争论已久的难题。而这也正是行业内称作 L3 级别自动驾驶、甚至是 L2 级别自动辅助驾驶急需解决的问题:用户到底该不该信任这一类“人工智能辅助的驾驶系统(AI-assisted driving system)”?

其实业界针对自动化场景下人类行为的研究已经有超过 70 年的历史了。之前的研究表明:人类在交出控制权很长一段时间后,会自然地对可信赖的自动化机器产生过度信任的感情。

于是,如何平衡用户信任和风险,成为了众多车企和自动驾驶公司的“抉择”。这迫使很多车企直接越过沼泽,放弃了这种中间状态的“L3 级别自动驾驶”——“与其在技术不成熟时把责任转嫁到消费者身上,倒不如真正踏实的致力于直接实现完全自动驾驶汽车。”

但是依旧有很多辅助驾驶功能带来的体验让用户“上瘾”,包括能够不断升级的特斯拉 Autopilot 系统。

其实针对 Autopilot 的安全性问题,业界对特斯拉颇有微词。上月,美国国家交通安全委员会(NTSB)发布的调查报告显示,3 月份发生在美国佛罗里达州的一起特斯拉致死事故中,车祸发生时 Autopilot 处于激活状态,且驾驶员双手并没有放在方向盘上。尽管特斯拉官方也一直在强调,Autopilot 属于辅助驾驶系统,开启后驾驶员仍要手扶方向盘保持注意力集中。但事实上,之前很多起致死事故中,车主几乎都处于“”的状态,完全将生命交给了一套功能仍有待完善的智能机器。

错误的特斯拉 Autopilot 系统使用示范 | 网络用户

“我们接受批评和建议,不过我们做的所有决定都是处于为客户最佳体验的考虑。”在今年第一季度的电话会议上,Elon Musk 解释说,“这些严重事故大部分都发生在经验丰富的驾驶员身上,这种盲目自信容易让人放松警惕,导致了悲剧的发生。”但 Musk 始终坚信自己的观点:“Autopilot 比任何传统汽车更加安全。”

针对这样的行业难题,MIT 花费三年时间,以上亿条的实验数据来说明、讨论和进一步拆解“信任”与“分险”以及“警惕性”之前的关联。这项研究的论文已经公开发布(下载地址:http://t.cn/ECAfpUp),文中详细记录了该实验的背景、操作方法、结论,同时对该研究存在的局限性进行了探讨。极客公园对其中的重点内容进行了梳理,下面和大家逐一分享。

MIT 的“信任系统”

早在 2016 年,麻省理工学院交通与物流中心的工作人员开始了一项特殊的针对自动驾驶技术的研究。通过搜集大量真实驾驶数据,利用深度学习算法进行分析,目的是探明人类与 AI 的互动机制,即“如何在不断提升道路安全的同时不牺牲驾驶的愉悦性”。

研究对象涵盖了 21 辆特斯拉车型(Model S 和 Model X),2 辆沃尔沃 S90,2 辆路虎揽胜极光以及 2 辆凯迪拉克 CT6。MIT 的工作人员要搜集的是这些车辆在自然运行状态下的驾驶数据,时间分为两个阶段:长期(驾驶时间超过 1 年)和短期(驾驶时间为 1 个月)。

实验中使用的不同车型,绝大多数为特斯拉Model S、Model X | MIT

这些车辆都经过了小规模的改装,额外加装了三个摄像头(一个用来监控驾驶员的面部特征,一个用来采集驾驶员的肢体语言,另一个主要搜集的是车头正前方的道路环境信息),除了这些摄像头提供的高分辨率视频流外,研究人员还会对来自 IMU、GPS、CAN 总线信息等数据进行记录,通过不断开发新的方法来分析这些海量数据。

目前这项研究仍在继续中,参与人数达到了 99 人,总行驶天数 11846 天,累积里程 40 多万英里,共搜集视频帧数 55 亿条。

而背后支撑这项研究的技术,是一套由 MIT 工作人员自行打造的软硬件系统 RIDER,又叫做“实时智能驾驶环境记录系统”,由它来进行数据的搜集和整理。这套系统除了有着灵活的硬件架构外,同时集成了大量的软件框架,能够将搜集到的传感器数据,借助 GPU 驱动的计算内核进行分析,最终得到自动驾驶场景下关于人类驾驶员行为的信息。

下面这张图可以帮助我们更好地理解从原始数据采集到最终信息输出的整个过程。其中高级别的步骤包括:1)数据整理和同步;2)自动或半自动数据标注,语义解读和信息提取;3)整体分析和视觉输出

实验中从原始数据采集到最终信息输出的整个过程 | MIT

值得一提的是,MIT 团队在这项研究的基础上还单独针对 Autopilot 系统进行了考察,目的是探究用户在使用 Autopilot 过程中是否会出现功能性警惕(functional vigilance)倒退的情况。

研究人员通过概念化的方式对“功能性警惕”这一指标进行了评估。它衡量的是驾驶员在使用 Autopilot 过程中的自我管理能力,比如何时何地选择开启这项功能,同时也清楚了解手动接管车辆的时机。

目前根据对数据分析的结果得知,尽管驾驶员开启 Autopilot 行驶的里程占总里程数的 34.8%,但他们保持了相对程度很高的功能性警惕。这个结论是基于对 18928 次 Autopilot 系统脱离情况的标注得出的,通过一定量级的采样证明了人类驾驶员在使用类似 Autopilot 这种人工智能辅助的驾驶系统时,对一些具有挑战性的场景依然能够及时做出反应。

传统研究驾驶员警惕性与MIT提出的“功能性警惕”的区别 | MIT

MIT 这项实验的主要目的是借助对搭载 Autopilot 特斯拉车型产生的真实驾驶数据进行分析,说明人机交互中常见的警惕性减退模式在 AI 辅助驾驶(AI-assisted driving,也叫做 L2 级自动驾驶,半自动驾驶等)并非固有的现象。这其中重要的意义在于,对企业在设计类似的基于人工智能的驾驶辅助系统时可能会有帮助,使驾驶员不会对机器过度信任,从而引发警惕性大幅降低的情况发生。

在论文的摘要部分,MIT 的工作人员表示,“希望这项研究能够引起业界的讨论和进一步的深入观察。即针对驾驶辅助系统设计和应用中,某些功能是如何对参与其中的人类驾驶员形成影响的。以及我们在使用类似技术时如何既能够保持与机器良好的协作性,同时不影响自己作为驾驶主体的警惕性和控制能力。”

耗时 3 年多的实验意义何在?

MIT 的整个研究是建立在人工智能以及机器人系统快速发展的全球化背景下进行的。就汽车而言,如何保证 AI 应用能够最大限度地提升驾驶安全并有效改善出行体验,而不是增加风险,这是关键。而解决类似问题的核心在于要对人工智能辅助驾驶场景下的人类行为有更深入的理解,对驾驶员保持警惕性的能力进行充分评估,进一步加深对机器局限性的了解。

因为在一个充满不确定性的世界里,平衡信任和风险至关重要,分秒之间的判断失误就可能导致灾难性后果的发生。

这项研究的着眼点是特斯拉的 Autopilot 系统。按照美国汽车工程学会 SAE 给出的定义和标准,它属于 L2 级自动驾驶系统,在人类驾驶员的监管下能够实现一定程度的自动驾驶。不过为了避免过度解读引起误解,MIT 的工作人员在论文中舍弃了“自动驾驶”和“自动化”这样的字眼,给予其“人工智能辅助的驾驶系统(AI-assisted driving system)”的定义,是为了说明 Autopilot 现阶段并不具备“全自动驾驶能力”,是一套始终需要人类监管的驾驶辅助系统。

由于特斯拉属于大规模量产的车型,因此 Autopilot 是目前个人使用率最高的驾驶辅助产品,它自然也成为研究和了解人类与 AI 交互模式最合适的对象。参与实验的特斯拉车型(Model S 和 Model X)具备多种高级驾驶辅助功能,但这项研究主要以自适应巡航(Traffic Aware Cruise Control,交通感知巡航控制,简称 TACC)以及车道保持(Autosteer,自动转向)功能为主,也就是说,特斯拉能够在三种模式下驾驶:1)手动模式;2)TACC;3)Autopilot(TACC 和 Autosteer 同时开启)。

在数据采样期间,由于特斯拉新一代 FSD 自动驾驶芯片还未发布,因此实验车型搭载的分别是 HW1.0 和 HW2.0 的硬件系统。其中 HW1.0 包括了雷达的传感器融合,超声波传感器以及由 Mobileye 开发的单目摄像头系统;而 HW2.0 有 8 个环视摄像头,提供车身 360°的环境感知能力,探测范围在 250 米,12 个升级的超声波传感器和 1 个前向雷达。参与数据采集的 21 辆特斯拉中,有 16 台搭载了 HW1.0,剩下的 5 台是 HW2.0。

截止到目前为止,从特斯拉 2015 年 10 月启用 Autopilot 开始,目前在该系统运行状态下特斯拉车型的总行驶里程数已经超过了 10 亿英里。不过即使拥有如此庞大的里程数据,我们对 Autopilot 系统在“何时、何地、以何种方式与人类进行互动”这些信息几乎知之甚少,所以 MIT 的研究人员希望借助真实世界的数据进行更客观、更有代表性的分析。

前面已经提到了,MIT 的团队提出了一种评估驾驶员“功能性警惕”的方法,通过概念化的方式衡量驾驶员在使用 Autopilot 过程中的自我管理能力,比如何时何地选择开启这项功能,同时也清楚了解手动接管车辆的时机。而评估驾驶员在 Autopilot 系统开启后对一些具有挑战性场景的反应能力时,研究人员专注的是“棘手场景(tricky situation)”,即如果不注意的话,可能会导致车辆损害以及人员伤亡的场景。

通过对 8682 起因遇到“棘手场景”而导致 Autopilot 自动脱离的情况进行分析研究,结果表明驾驶员在使用 Autopilot 过程中依然保持着很高程度的警惕,而符合这种情况的里程数占数据总量的 34.8%。这种对驾驶员何时、何地自主选择使用 Autopilot 能力的考察也是传统方法研究驾驶员警惕性与 MIT 提出的“功能性警惕”的一大区别。

这项研究最终得出两个结论:

1)在提供的真实驾驶数据中,特斯拉车主使用 Autopilot 的行驶里程占比非常高;2)驾驶员在 Autopilot 系统开启时并没有出现因过度信任而出现警惕性明显下降的现象。简而言之,基于 MIT 获取的真实数据得知,用户使用特斯拉 Autopilot 的频次很高,期间依然保持了相应程度的功能性警惕。下面的表格通过详实的数据对上述第二个结论进行了说明。

表I-实验人员对 Autopilot 的脱离次数进行标注 | MIT

MIT 这项研究使用的数据来自于 21 辆搭载了 Autopilot 系统的特斯拉车型,总行驶里程达到了 32.3384 万英里。这些车型均为私人所有,除上面提到的改装部分外,MIT 的团队没有对这些车辆的行驶范围,Autopilot 开启时间以及驾驶方式做任何限制,也没有提供任何建议和指导。如下图所示,该数据集中涵盖的大部分的行驶区域位于大波士顿和新英格兰地区,同时额外增加了从马萨诸塞州到加州和佛罗里达州的行驶数据。

红色代表了手动模式下车辆的形势轨迹,而蓝色代表了 Autopilot 模式下车辆的行驶轨迹 | MIT

在人工标注数据的过程中,工作人员需要同时观看来自三个摄像头采集的视频数据,而 Autopilot 相关系统的状态,车辆的运动学特征以及其他相关信号则采集自一条 CAN 总线输出的信息。而整个数据集中,包含了 2.6638 万条关于 Autopilot 使用情况的“时间戳”。这里一个 Autopilot 时间戳的定义为,从驾驶员开启 Autopilot 算起到因人为或系统原因脱离为止的一段时间。而本项研究中针对“功能性警惕”的分析则重点集中在这个时间戳前 5 秒后 10 秒的数据部分。

此外,要对驾驶员的“功能性警惕”进行评估还需要对造成 Autopilot 系统脱离的“关键事件(critical events,简称 CE)”进行统计。MIT 的研究人员将其分成四类:CE1、CE2、CE3、CE4,其中对各自的定义如下:

CE1:针对“棘手场景”,因为提前预知或及时作出反应,人类驾驶员主动脱离 Autopilot 系统;CE2:在遇到“棘手场景”时,Autopilot 因无法解决而自动脱离;CE3:在 Autopilot 运行时突然减速(例如,急踩刹车等),导致系统脱离;CE4:在 Autopilot 运行时遭遇“棘手场景”,但未发生系统脱离或引起任何事故。

我们能发现些什么?

1. 模式使用情况

如下图所示,数据集中覆盖了 32.3384 万英里的总行驶里程,其中有 11.2427 万英里是在 Autopilot 运行工况下完成的,换算成相应的比例则是 34.8% 的里程以及 15.1% 的运行时间。从这两个数字可以看出 Autopilot 的使用频次非常高,驾驶员通过使用这套系统获得了相应的价值。相反,TACC 功能的开启时间只有 3%,因此在 MIT 的研究中,忽略了对该工况的分析,主要精力放在了手动和 Autopilot 两种模式下的对比,因为它们构成了 97% 的使用时间。

就目前观察到的 Autopilot 系统的脱离情况来看,目前 Autopilot 仍处于技术发展初期,还具有不完善的地方,而它现在表现出的可依赖性决定了人类驾驶员对其产生的信任以及表现出的功能性警惕程度。

试验车辆在手动、TACC 以及 Autopilot 工况下的使用时间及行驶里程 | MIT

2. Autopilot 运行时驾驶员的“功能性警惕”表现

在 MIT 这项研究中,对“功能性警惕”的衡量,需要考察的是驾驶员能否及时有效地探查出 CE1 和 CE2 这两种“关键事件”的发生。

在被标注的 18928 个 Autopilot 时间戳中,有 8729 个被贴上了“棘手场景”的标签,具体详情请查看表 I 的描述。而针对这个问题的分析,主要目标是得到标注了“应对棘手场景太迟”信息的时间戳数量。这些时间戳指的是没有探查出或者对“关键事件”反应太慢,进而导致驾驶员“功能性警惕”大幅减退。从表 I 提供的信息来看,在 MIT 研究的数据集中,并没有类似的情况出现。

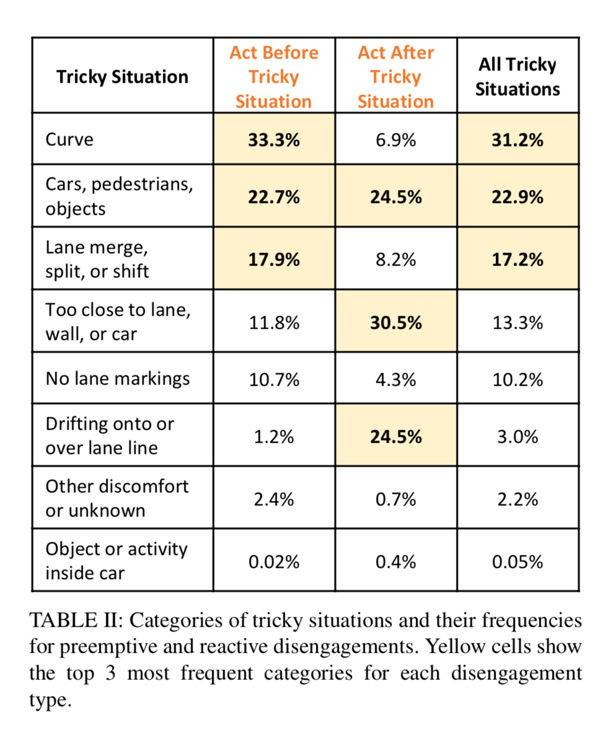

表 II 对“棘手场景”以及引起 Autopilot 系统脱离的频次进行了说明。“出现了一条弯道”是对系统脱离最常见的预判理由,而“车辆离车道、墙或者另一辆车太近了”是主动脱离系统最常见的原因。

这项数据分析得出的结果对今后人工智能辅助的驾驶系统的设计具有重要的指导性作用,毕竟这类产品的目的是高效应对那些人类驾驶员认为“棘手”的驾驶场景。

表II-对“棘手场景”的分类以及因主动脱离 Autopilot 系统的情况中这些场景的发生频次 | MIT

“不要因为美好的事物不够完美而反对它”

在对 Autopilot 的模式使用情况以及驾驶员“功能性警惕”进行评估分析后,MIT 的研究人员发现,在考察的数据集中,用户使用 Autopilot 的频次非常高,但并没有对这套系统产生过度依赖从而导致功能性警惕的大幅衰减。他们针对这样的结论提出了两个原因的假设:1)探索性的心理;2)产品功能仍有待完善。后者可能是导致出现我们观察到的驾驶员行为的重要原因。

从数据统计上来看,驾驶员平均每 9.2 英里就会遭遇 1 次“棘手场景”,在这种情况下,驾驶员能够提前预知何时、何地会出现这种“棘手场景”或者及时脱离 Autopilot 系统,这占据了总行驶时间的 90.6%。在其他 4.5% 的情况中,驾驶员能够对系统脱离或“棘手场景”立即作出反应,这充分表明了他们的“功能性警惕”程度非常高。

下面我们对上述两个假设的原因做分别详细的说明:

1)探索性的尝试

在 MIT 研究的数据集中,绝大多数 Autopilot 运行的时间和区间都是在高速公路上自由行驶产生的,但也有部分 Autopilot 的脱离记录发生在普通道路上(比如没有限速要求等的区域)。这可能说明了用户一般情况下都会去探索类似系统在“设计运行区域”(opertioanl design domans,简称 ODD)之外场景工作的能力。这种通过探索学习的方式可能会让用户更深入地了解类似驾驶辅助系统能力的局限性,进而用于应对论文中描述的各种“棘手场景”。

而之所以提出这种假设,是基于 MIT 团队与特斯拉车主的讨论以及通过真实道路驾驶数据的分析得出的。未来通过更大量的数据以及进一步的分析,这个假设很可能会得到进一步验证,但也有可能会被推翻。

2)产品功能仍有待完善

就目前业界获得的共识,作为一种基于人工智能技术打造的驾驶辅助系统,Autopilot 并非有足够的能力来应对驾驶过程中可能发生的任何极端事件。从 MIT 研究的数据来看,46.2% 的系统脱离是因为人类驾驶员预料到或因为遭遇了“棘手场景”发生的,而换算成相应的比率,在 Autopilot 运行过程中,这种类型的脱离情况平均每 9.2 英里就会发生一次。这意味着 Autopilot 系统经常会变得“不靠谱”,需要人类驾驶员及时进行接管。因此从工程角度出发考虑,基于这样的数据,今后的产品应该要将这种“失误率”降得更低才行。

简单来说,驾驶员知道 Autopilot 并不完美,以及驾驶员在尝试 Autopilot 更多的使用场景,此两种情况都让驾驶员格外专注。这才使得驾驶员的“功能性警惕”并未出现大幅衰退。换言之,“不要因为美好的事物不够完美而反对它”。

一套表现出色的 AI 辅助驾驶系统可能还达不到 99.99…% 的完美,但首先企业应该清楚地认识到它的不完善性,并将这个认识完整的传递给消费者,并持续改进迭代使其朝着更完方向发展,这才是设计产品应该有的逻辑。

Autopilot 们,前路何方?

尽管 MIT 的这项研究表明,在 Autopilot 使用过程中,人类驾驶员的“功能警惕性”并未出现大幅衰减。然而我们可能还是不太清楚类似 Autopilot 这样的基于 AI 的驾驶辅助系统该如何设计,才能最大程度优化“功能性警惕”的表现。

MIT 的研究人员认为有两条建议可能会对驾驶员“功能性警惕”框架的管理产生潜在的有益影响,详细内容见下图。

两种对现有“功能性警惕”框架的扩充方式 | MIT

1)第一种是建立反馈闭环的机制。

它包括了对驾驶员状态感知和管理的概念,允许机器对作为整套系统监管者的驾驶员进行监控,在探测到功能性警惕减退,注意力不集中或任何偏离合理表现的行为时给予警告。而要实现这样的监管,可以采取在方向盘上加装传感器或增加基于摄像头的驾驶员监控系统 DMS(例如凯迪拉克的 Super Cruise 就配备了类似的技术)。

MIT 实验中通过安装朝向驾驶员面部的摄像头对其进行更好的监控 | MIT

2)第二种是配置额外的感知控制系统。

通过增加第三方的系统作为对车辆主要自动驾驶系统的监管,在主驾驶系统提供感知和决策功能的同时,一旦出现异常能够及时提供冗余保护。

总的来说,这两种 MIT 提出的建议互相配合,目的是为功能性警惕框架中人类和机器的表现进行更好的管理。此外,这也有助于在驾驶过程中遇到 CE4 这类“关键事件”时,能够提供额外的保护。因为受限于实验数据库样本数量的限制,目前还没有监测到该事件的发生,但在真实道路环境中 CE4 这种情况是存在的。

所以 MIT 的工作人员认为这项研究同样存在着一定的局限性,譬如无法基于实验的分析来说明 Autopilot 这套系统的安全性如何,因为需要对碰撞相关的数据进行分析,也就是说目前的数据量还不够。此外,他们认为类似 DMS 这种注意力管理系统如果能在“功能性警惕”框架上进行应用的话,是能够鼓励驾驶员更专注于道路交通状况的。

不过特斯拉 CEO 埃隆•马斯克可能并不这么认为。他在与 MIT 的助理研究员 Lex Fridman 进行一场线上对谈时是这么说的:

If you have a system that's at or below a human level of reliability, then driver monitoring makes sense. But if your system is dramatically better, more reliable than a human, then driver monitoring does not help much.“如果这套驾驶辅助系统和人类一样可靠,或者说还不如你,那么驾驶员监控系统 DMS 的存在是必要的。但如果你使用的是 Autopilot,它太棒了,比人类都要靠谱得多,所以特斯拉的车上并不需要安装 DMS。”

马斯克的“谜之自信”

Fridman 在访谈中也提到了产品的“设计运行区域”问题。相比之下,通用凯迪拉克的 Super Cruise 只能在已经完成高精度地图测绘的、固定的高速公路区域行驶,从 ODD 的层面来说,它要比 Autopilot 窄得多。不过在他看来,这种产品设计的逻辑有利有弊。好处是特斯拉的车主能够更充分地了解到 Autopilot 系统的局限性,特别是在最开始使用的时候,配合仪表显示器的信息,他们能够对可实现的驾驶辅助功能有足够的认知。但坏处是,Autopilot 几乎可以在任何区域使用。

针对此马斯克回应称,“只要系统能够感知道路的地方,就是 Autopilot 可以运行的区域。”他同时指出,“老实说,我觉得让人开着两顿重的死亡机器是件很疯狂的事情。未来人肯定是要被剥夺掉驾驶权的,那个时候你想去哪里,汽车会通过自动驾驶的方式来实现。”

而在问及技术层面上要实现全自动驾驶需要解决哪些难题时,马斯克的回答蛮有意思的。

他说,“我们在前不久推出的 FSD 计算平台已经投入量产,它具备实现全自动驾驶的基础计算能力,剩下的神经网络和控制软件,我们可以通过后续的 OTA 不断迭代。所以特斯拉车型的软件能力今后会有突破,Autopilot 系统的可靠性也会大幅提升,未来只需要得到监管层面的许可就可以了。”马斯克甚至把购买特斯拉比作是“投资未来”,他认为“特斯拉是一件具备升值能力的产品。”

而在问题重新回到“人”这个着眼点时,Fridman 认为目前像 Waymo、Uber 这些在进行道路测试的公司,只是技术上所谓的 L4 级自动驾驶,实际上它们属于有着不同设计逻辑的 L2 级系统,因为总是会有一个安全员全程参与,时刻监视着机器的运行。所以他向马斯克提出了这么一个问题,“既然你说特斯拉的 Autopilot 已经具备了自动驾驶的计算能力,什么时候你认为它才能够不需要人类的监管,实现真正的无人驾驶呢?”

对此,马斯克回答称,“从现在开始,Autopilot 至少还需要 6 个月的时间去监测驾驶员是否把手放在方向盘上。而且主要问题是,从政府监管部门的角度出发,Autopilot 需要达到比人驾驶多高的安全程度,才可以将人的驾驶权去掉。业界针对这个问题有很多争论,你需要大量的数据来证明,机器开车要比人安全得多。我认为,这个比率需要达到 200% 或 300% 才可以。”

“至于我是如何得出这个数据的,”马斯克答道,“主要是根据每英里发生事故的频次进行推算的。目前从规模上来看,我们没有获得那么多关于交通致死的数据,所以主要是基于交通事故率来分析的。其他的,比如受伤的概率,包括永久伤害或死亡的可能性,也在分析范围内,最后计算出来的比例,至少机器要比人靠谱 200% 以上才可能不需要被监管。”

Autopilot 的阿克琉斯之踵

其实针对 Autopilot 的安全性问题,业界对特斯拉颇有微词,特别是上个月召开的投资者大会上,马斯克对友商们“使用激光雷达的做法一顿喷”更是激起了自动驾驶技术领域的激烈讨论。不过就像 MIT 这项研究给出的结论,Autopilot 目前仍有许多不足,还需要不断完善,所以驾驶员在系统运行时需要对车辆实时监控,一旦有危险的征兆或棘手的情况发生,手动接管是最安全稳妥的。

上月,美国国家交通安全委员会(NTSB)发布的调查报告显示,3 月份发生在美国佛罗里达州的一起特斯拉致死事故中,车祸发生时 Autopilot 处于激活状态,且驾驶员双手并没有放在方向盘上。

尽管特斯拉官方也一直在强调,Autopilot 属于辅助驾驶系统,开启后驾驶员仍要手扶方向盘保持注意力集中。但事实上,之前很多起致死事故中,车主几乎都处于“拖把”的状态,完全将生命交给了一套功能仍有待完善的智能机器。这也是为什么 MIT 的团队给出了额外的建议,希望 Autopilot 能配置相应的驾驶员监控系统,同时还应该做好相应的冗余配置,一旦驾驶员松开方向盘立即给予声音和视觉层面的警告是十分必要的。

但在马斯克看来,Autopilot 的能力远在人类驾驶员之上,不需要增加类似 DMS 这种额外的功能。而这种对自己产品的“迷之自信”映射到产品上,也成了 Autopilot 的阿克琉斯之踵。

从 2018 年第三季度开始,特斯拉陆续公布了一系列车辆安全报告,提供本季度特斯拉车辆造成的事故数量(无论 Autopilot 是否启用)。根据从官网获取的信息来看,2018 年 Q3,Autopilot 开启状态下的平均事故率为每 334 万英里发生一起,而手动模式下的平均事故率为每 192 万英里发生一起。而 2019 年 Q1 的最新数据显示,这两个数字均有下降,分别为 1 起/287 万英里、1 起/176 万英里。

特斯拉每个季度会在官网发布车辆安全报告 | Tesla

而美国国家交通公路安全管理局(NHTSA)公布的最新数据,全美境内乘用车的事故率为平均每 43.6 万英里会出现一例,它包括了所有安装与未安装类似 Autopilot 系统的车辆。对比来看,特斯拉似乎依然配得上“世界上最安全汽车”的头衔。

尽管 Autopilot 这套系统仍有很多缺点,但毫无疑问它从很大程度上改变了用户的驾乘体验。比如特斯拉已经去年 10 月在北美开放了 Navigate on Autopilot 功能,支持自动驶入和驶出高速公路闸道,同时还能实现自动并道,这已经接近限制场景下(高速公路等)的 L3 级自动驾驶能力。

在上个月面向投资人的“Autonomy Day”活动中,马斯克表示“2020 年将实现全自动驾驶的目标。”尽管外界对这一说法充满了质疑,但随着 FSD 计算平台的加持,Autopilot 的自动化能力正朝着更高水平迭代,已经是不争的事实。

但更重要的是,一套表现出色的 AI 辅助驾驶系统可能还达不到 99.99…% 的完美,但首先企业应该清楚地认识到它的不完善性,并将这个认识完整的传递给消费者,并持续改进迭代使其朝着更完美的方向发展,这才是设计产品应该有的逻辑。